随着数据科学的飞速发展,Kaggle比赛成为了数据科学家们展示实力、交流技术的重要平台,梯度提升决策树(GBDT)作为一种强大的机器学习算法,在Kaggle比赛中得到了广泛的应用,本文将介绍如何在Kaggle比赛中使用GBDT代码。

了解Kaggle比赛

Kaggle是一个数据科学社区,定期举办各类数据科学比赛,涵盖各个领域,参赛者需要利用机器学习和数据分析技术,对特定问题进行建模和预测,比赛不仅提供了丰富的数据集,还有诸多奖项等待优秀选手的挑战。

认识GBDT算法

梯度提升决策树(GBDT)是一种基于决策树的集成学习方法,它通过构建多个决策树,并将它们组合成一个强大的模型,以提高预测性能,GBDT在处理复杂非线性关系方面表现出色,因此在许多Kaggle比赛中受到青睐。

GBDT代码实践

在Kaggle比赛中使用GBDT,通常需要以下步骤:

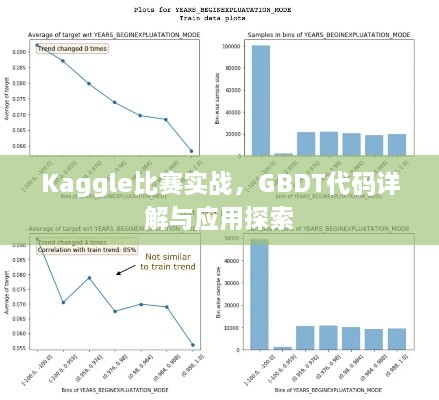

1、数据准备:收集并整理比赛所需的数据,对数据进行预处理,如缺失值填充、特征工程等。

2、特征选择:选择对预测目标影响较大的特征,以提高模型的性能。

3、模型训练:使用GBDT算法训练模型,在Python中,可以使用sklearn库中的GradientBoostingClassifier或XGBoost库来实现。

4、模型评估:通过交叉验证、绘制学习曲线等方式评估模型的性能,调整模型参数以优化性能。

5、预测提交:使用训练好的模型对测试集进行预测,并提交预测结果。

下面是一个简单的GBDT代码示例:

导入所需库

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.ensemble import GradientBoostingClassifier

from sklearn.metrics import accuracy_score

加载数据

data = pd.read_csv('kaggle_data.csv')

数据预处理

...

特征和目标变量分离

X = data.drop('target', axis=1)

y = data['target']

划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

创建GBDT模型

gbdt = GradientBoostingClassifier()

模型训练

gbdt.fit(X_train, y_train)

预测测试集

y_pred = gbdt.predict(X_test)

评估模型性能

accuracy = accuracy_score(y_test, y_pred)

print('Accuracy:', accuracy)注意事项与优化策略

在Kaggle比赛中使用GBDT时,需要注意以下几点:

1、特征工程:通过特征选择、特征组合等方式提高模型的性能。

2、参数调整:根据数据集的特点和比赛要求,调整GBDT模型的参数,如决策树数量、学习率等。

3、交叉验证:通过交叉验证评估模型的性能,避免过拟合和欠拟合问题。

4、集成学习:可以尝试将GBDT与其他机器学习算法结合,形成更强的模型。

5、代码优化:关注代码效率,对于大型数据集,可能需要使用更高效的数据处理方法和算法。

本文介绍了如何在Kaggle比赛中使用GBDT代码,通过了解Kaggle比赛、认识GBDT算法、实践GBDT代码以及注意事项与优化策略,读者可以更好地应用GBDT算法参加Kaggle比赛,提高数据科学技能。

转载请注明来自泰安空气能_新泰光伏发电_泰安空气能厂家|品质保障,本文标题:《Kaggle比赛实战,GBDT代码详解与应用探索》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...