随着大数据技术的日益成熟,数据仓库如Hive在数据处理和分析中的重要性愈发凸显,本文将围绕“12月实时增量数据接入Hive”这一主题,探讨数据实时接入Hive的要点,包括面临的挑战、解决方案及最佳实践。

一、引言

在当今数据驱动的时代,数据的实时性对于业务决策至关重要,特别是在12月这样的消费旺季,企业面临着处理海量实时增量数据的挑战,Hive作为构建在Hadoop之上的数据仓库基础架构,提供了海量数据的存储和查询功能,将实时增量数据快速、高效地接入Hive,一直是数据工程师们关注的焦点。

二、要点一:面临的挑战

1、数据实时性要求高:随着业务的发展,对数据的实时性要求越来越高,传统的批处理模式无法满足对毫秒级、秒级数据的处理需求。

2、数据量大且复杂:12月作为消费旺季,数据量急剧增长,数据类型多样且复杂,处理难度加大。

3、系统整合难题:如何将实时增量数据从源头系统高效地接入Hive,同时确保数据的一致性和完整性,是另一个亟待解决的问题。

三、要点二:解决方案

针对上述挑战,以下是一些解决方案:

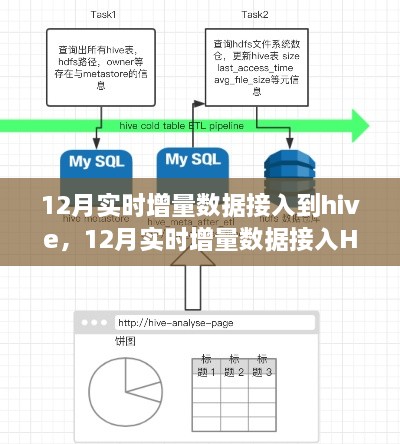

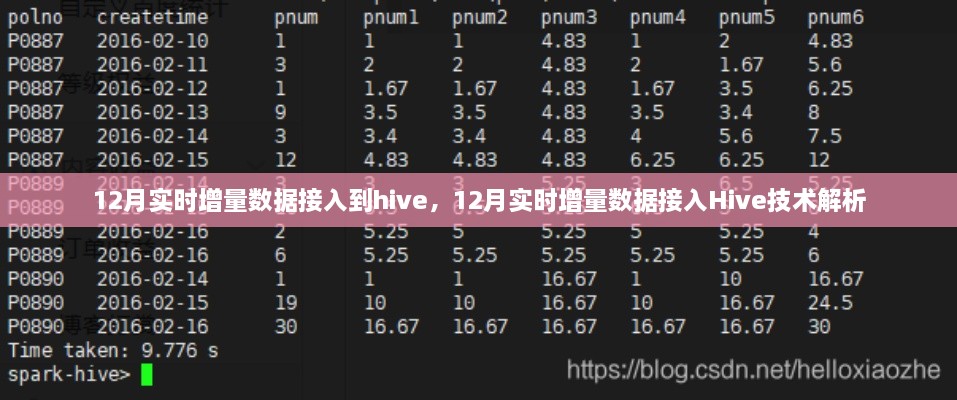

1、引入实时数据流处理框架:采用如Apache Flink、Apache Beam等流处理框架,实现数据的实时采集、转换并加载到Hive中,这些框架能够处理高并发数据流,保证数据的实时性。

2、使用Kafka作为缓冲层:利用Kafka的高吞吐量和低延迟特性,将实时增量数据先写入Kafka,然后设置消费者将数据消费到Hive中,这种方式能够解耦数据产生和处理的速率,保证数据的实时接入。

3、优化Hive写入策略:采用Hive的批量写入接口(如Hive Bulk Insert),提高写入效率,利用HDFS的高并发写入特性,分散I/O压力,加速数据加载。

四、要点三:最佳实践

在实际操作中,应遵循以下最佳实践以确保实时增量数据的高效接入:

1、数据清洗与预处理:在数据接入Hive之前,进行必要的数据清洗和预处理工作,确保数据的准确性和一致性。

2、合理设计数据接口和架构:设计高效的数据接口和架构,确保实时数据流能够顺畅地接入Hive,同时降低系统复杂度。

3、监控与告警机制:建立有效的监控和告警机制,实时监控数据的接入情况,及时发现并处理潜在问题。

4、定期优化和调整:根据业务需求和实际运行情况,定期优化和调整数据接入策略,确保系统的性能和稳定性。

五、总结

将12月的实时增量数据接入Hive是一个复杂而又关键的任务,通过引入实时数据流处理框架、使用Kafka作为缓冲层以及优化Hive写入策略等解决方案,可以有效应对数据实时性要求高、数据量大且复杂以及系统整合难题等挑战,在实际操作中,应遵循数据清洗与预处理、合理设计数据接口和架构、建立监控与告警机制以及定期优化和调整等最佳实践,只有这样,才能确保实时增量数据的高效、稳定接入,为企业的业务决策提供更准确、更及时的数据支持。

转载请注明来自泰安空气能_新泰光伏发电_泰安空气能厂家|品质保障,本文标题:《12月实时增量数据接入Hive技术解析与操作指南》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...